- サービス

Excelだからできた、戦略的「予実」管理

~ ただの比較じゃ意味が無い ~

予実管理のデータ登録が負担に 営業時間が犠牲になる本末転倒 P社はBtoBの消耗品を扱う販...

Excel専門|マクロ+システム開発で業務改善

| 業種 | |

|---|---|

| 利用規模 | |

| 用途 | |

| 解決した問題 |

| 導入目的 | 膨大なデータを、様々な切り口で分析したい。 |

|---|---|

| 課題 | 分析のルールを試行錯誤する |

| 効果 | 複数要素の組み合わせでの絞込みが可能になるなど、想定した以上の自由な加工が可能 |

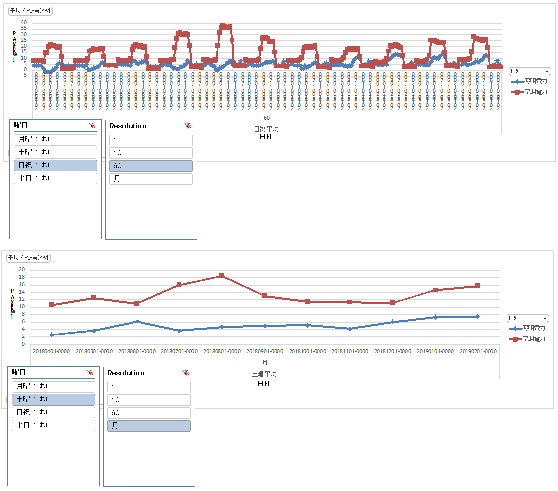

T大学では、1秒=1件で生成される計測データを使って、日別、週別、曜日別などの視点を組み合わせて、様々な分析を試みたいと考えていました。

分析結果は研究成果に反映させるため、二次加工のしやすいExcelで加工することが条件でした。

とはいえ、データ量が膨大なのと、そもそもどうやって分析するかが試行錯誤の繰り返しのため、

分析のための明確なルールが定められていません。

そこで、データ加工とともに、これらを分析するためのツールについて、ある程度「お任せ」状態でご相談を戴きました。

データは計測日時情報を持っていますが、時間別・日別などの平均をとるためには、1時間=3600件、1日=86400件・・・といった大量の集計(平均)が必要になります。

仮にデータベースを使っても、相当な処理能力を持たせないと、短時間で処理ができません。

そこで、切り口が決まっているのを幸いに、事前に集計したデータを用意して置き、目的に応じてデータを切り替える方針としました。

すなわち、1時間単位の平均、1日単位の平均・・・月曜日の平均、火曜日の平均・・・といった具合に、予め集計(計算)しておくのです。

事前の加工にはある程度時間を要しますが、集計(平均)の計算そのものをリアルタイムで行う必要はありません。

集計したデータをどのように見せるかについては、もともと方針が明確になっていなかったこともあり、当社のこれまでのデータ加工ニーズでのノウハウを基に、ある程度独断で機能化を図りました。

この結果、「曜日別×時間軸別」の組み合わせで絞り込みができるなど、もともと想定していた以上の粒度で加工ができるとの評価を得られ、「御社のデータグラフ化の技術には大変感銘を受けました」とのコメントを戴きました。

大量データの分析といえば、BI(Business Intelligence)ツールが有名ですが、高額なのに加え、操作方法に慣れが必要なため、二の足を踏みがちです。

特に、研究開発目的のようなケースでは、「走りながら決める」、すなわち何度もトライ&エラーを必要とします。

こうした場合、気軽にやってみることができ、そのまま他の加工につなげる「二次加工」がしやすいので、使い慣れたExcelでデータの切り替えや絞り込みができるメリットが最大限に活きています。

大量データの加工に時間がかかることから、予め集計(サマリー)しておくと、処理時間が圧倒的に短縮できます。

他の用途では、日々増加するデータに対して、毎朝定時に自動加工する、タイマー起動を実現しています。